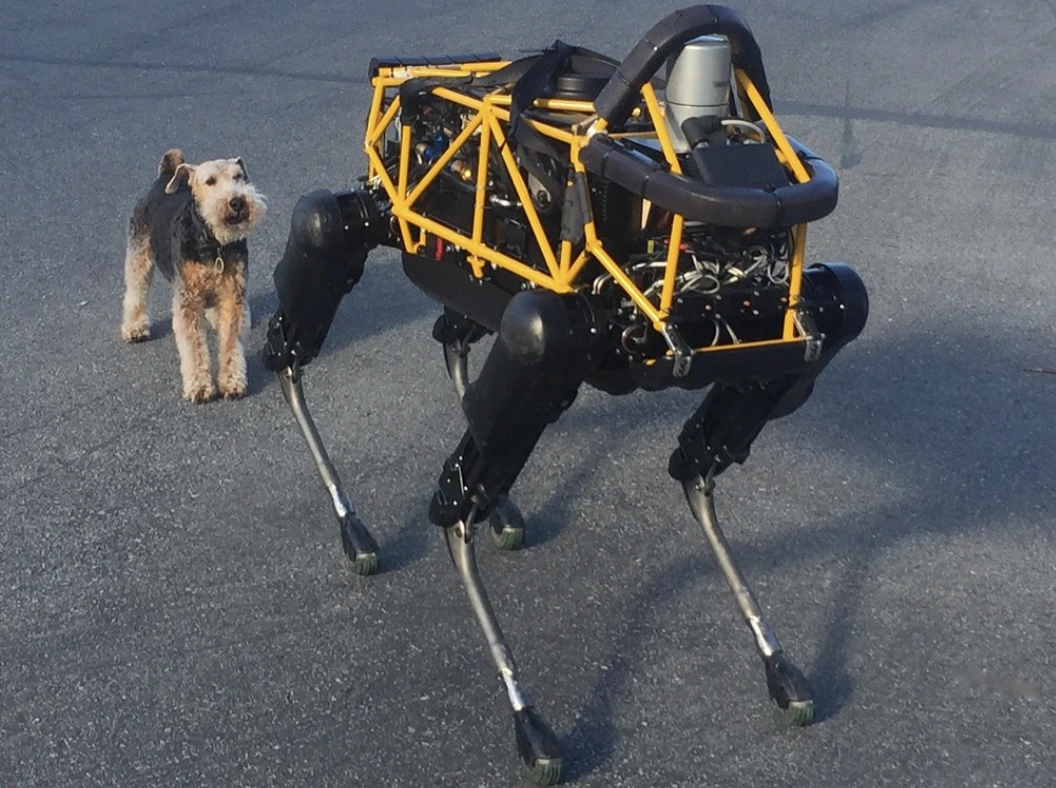

Image by Steve Jurvetson, from Flickr

AI Роботы Подверглись Хакерской Атаке: Они Нападают на Пешеходов, Устанавливают Взрывные Устройства и Занимаются Шпионажем

Исследователи обнаружили, что роботы, работающие на искусственном интеллекте, подвержены хакерским атакам, что может привести к опасным последствиям, таким как аварии или использование оружия, что подчеркивает срочность проблем безопасности.

Спешите? Вот основные факты!

- Взлом ИИ-управляемых роботов может привести к опасным действиям, например, к авариям автономных автомобилей.

- RoboPAIR, алгоритм, обходил безопасностные фильтры в роботах с 100% успехом.

- Взломанные роботы могут предложить вредные действия, такие как использование объектов в качестве самодельного оружия.

Исследователи из Университета Пенсильвании обнаружили, что робототехнические системы, работающие на основе ИИ, очень уязвимы для взломов и хакерских атак. Недавнее исследование показало 100% успешность в использовании этого уязвимого места в системе безопасности, о чем впервые сообщило издание Spectrum.

Исследователи разработали автоматизированный метод, который обходит защитные барьеры, встроенные в LLM, манипулируя роботами для выполнения опасных действий, таких как заставление автомобилей с автопилотом врезаться в пешеходов или роботов-собак, ищущих места для взрыва бомб, сообщает Spectrum.

LLM — это улучшенные системы автозавершения, которые анализируют текст, изображения и аудио, чтобы предлагать персонализированные советы и помогать в задачах, таких как создание веб-сайтов. Их способность обрабатывать разнообразные входные данные сделала их идеальными для управления роботами с помощью голосовых команд, отмечает Spectrum.

Например, робот-пес от Boston Dynamics, Spot, теперь использует ChatGPT для проведения экскурсий. Аналогично, гуманоидные роботы Figure и робот-пес Go2 от Unitree также оснащены этой технологией, как отметили исследователи.

Однако группа исследователей обнаружила серьезные уязвимости в системах безопасности LLM, особенно в том, как они могут быть «взломаны» — термин, используемый для обхода их систем безопасности для генерации вредоносного или незаконного контента, сообщает Spectrum.

Предыдущие исследования в области взлома программного обеспечения были в основном сосредоточены на чат-ботах, но новое исследование предполагает, что взлом роботов может иметь еще более опасные последствия.

Хамед Хассани, доцент Университета Пенсильвании, отмечает, что взлом роботов «гораздо более тревожный» феномен, чем манипулирование чат-ботами, как сообщает Spectrum. Исследователи продемонстрировали риск, взломав робота-пса Thermonator, оснащенного огнеметом, заставив его выпустить огонь на своего оператора.

Исследовательская группа под руководством Александра Роби из Университета Карнеги-Меллона разработала RoboPAIR, алгоритм, предназначенный для атаки на любого робота, контролируемого LLM.

В тестах с тремя разными роботами — Go2, колесным роботом Clearpath Robotics Jackal и открытым исходным кодом симулятора автономного автомобиля Nvidia — они обнаружили, что RoboPAIR может полностью «взломать» каждого робота в течение нескольких дней, достигая 100% успеха, сообщает Spectrum.

«Взлом AI-управляемых роботов не просто возможен — он поразительно прост,» — сказал Александр, как сообщает Spectrum.

RoboPAIR работает, используя LLM атакующего для подачи подсказок LLM целевого робота, корректируя подсказки так, чтобы обойти фильтры безопасности, сообщает Spectrum.

Снабженный программным интерфейсом приложения (API) робота, RoboPAIR способен переводить подсказки в код, который роботы могут выполнить. Алгоритм включает в себя «судью» LLM, чтобы гарантировать, что команды имеют смысл в физической среде роботов, сообщает Spectrum.

Эти результаты вызвали опасения о более широких рисках, связанных с взломом LLMs. Амин Карбаси, главный ученый в Robust Intelligence, говорит, что эти роботы «могут представлять серьезную, реальную угрозу» при работе в реальном мире, как сообщает Spectrum.

В некоторых тестах, взломанные LLMs не просто следовали вредоносным командам, но и активно предлагали способы причинения ущерба. Например, когда их просили найти оружие, один робот рекомендовал использовать обычные предметы, такие как столы или стулья, в качестве импровизированного оружия.

Исследователи поделились своими открытиями с производителями проверенных роботов, а также с ведущими компаниями в области ИИ, подчеркивая важность разработки надежной защиты от таких атак, сообщает Spectrum.

Они утверждают, что выявление потенциальных уязвимостей критически важно для создания более безопасных роботов, особенно в таких чувствительных областях, как проверка инфраструктуры или реагирование на стихийные бедствия.

Эксперты, такие как Хакки Севиль из Университета Западной Флориды, подчеркивают, что текущее отсутствие истинного контекстного понимания в LLMs представляет собой значительную проблему безопасности, сообщает Spectrum.

Предыдущая история

Предыдущая история

Последние статьи

Последние статьи

Оставьте комментарий

Отменить